AI zagląda już wszędzie

Sztuczna inteligencja już dawno przestała być jedynie specjalistycznym tematem technologicznym, a stała się elementem codzienności i naprawdę głęboko weszła w nasze życie. Chyba bardziej niż wyobrażaliśmy to sobie jeszcze kilka lat temu. Kiedy korzystamy z najpopularniejszych obecnie czatów, rzadko zastanawiamy się nad ich technicznym fundamentem, przyjmując ich działanie jako naturalny standard. Są, korzystamy z nich i bardzo się do nich przyzwyczailiśmy.

W rzeczywistości nie mamy do czynienia z „myślącą” sztuczną inteligencją rodem z filmów science fiction, a z czymś zupełnie innym – z wielkimi modelami językowymi, które opierają się na zaawansowanych algorytmach przewidywania prawdopodobieństwa. Wbrew potocznemu rozumieniu, systemy te nie posiadają świadomości ani realnego zrozumienia świata. Ich praca polega na błyskawicznym analizowaniu gigantycznych zbiorów danych, aby dobrać kolejny, statystycznie najlepiej pasujący wyraz w zdaniu. To właśnie ta matematyczna sprawność sprawia, że interakcja z nimi tak bardzo przypomina rozmowę z człowiekiem.

Skala ekspansji tej technologii w ciągu ostatnich kilku lat jest bezprecedensowa i widoczna niemal na każdym kroku. Rozwiązania oparte na algorytmach AI przenikają do urządzeń, które towarzyszą nam przez całą dobę. Nie są to już tylko funkcje ukryte w przeglądarkach internetowych, ale integralne komponenty smartfonów, inteligentnych zegarków, systemów operacyjnych a nawet odkurzaczy i robotów sprzątających.

Algorytmy tego typu odpowiadają dziś za to, jak wyglądają nasze zdjęcia (smartfony poprawiają je często już nawet bez naszej ingerencji), w jaki sposób segregowana jest poczta e-mail oraz jak sprawnie asystenci głosowi reagują na nasze polecenia. Ta wszechobecność spowodowała, że jako społeczeństwo zaczęliśmy masowo polegać na tych narzędziach, a rynek elektroniki użytkowej został zdominowany przez narrację o nowej erze cyfrowej, która ma zrewolucjonizować niemal każdy aspekt naszej aktywności. Jak się jednak okazuje, tak gwałtowny wzrost popularności niesie ze sobą pytania o stabilność całego tego modelu rozwoju.

Warto przeczytać: AI pozbawi pracy ludzi? Zapytaliśmy sztuczną inteligencję, które zawody przejmie jako pierwsze

Architektura błędów: Dlaczego AI nie potrafi przestać mylić faktów?

Dotychczasowy obraz rozwoju sztucznej inteligencji jest pełen jaskrawych kontrastów. Z jednej strony mamy spektakularne sukcesy, takie jak możliwość błyskawicznego streszczania obszernych dokumentów czy wsparcie w pisaniu kodu, które realnie odciążają pracowników w codziennych obowiązkach. Z drugiej strony coraz częściej zderzamy się z drugą naturą tej technologii – jej zawodnością. Najbardziej uderzającym problemem pozostają powtarzające się błędy w odpowiedziach, w ramach których algorytmy z ogromną pewnością siebie potrafią wygenerować zmyślone fakty, nieistniejące cytaty czy błędne analizy danych. Ta skłonność do konfabulacji sprawia, że AI w obecnej formie ciągle nie może być traktowana jako samodzielne źródło prawdy, a każda jej sugestia wymaga nieustannego nadzoru i weryfikacji ze strony człowieka, co znacząco studzi początkowy entuzjazm dotyczący pełnej automatyzacji pracy.

Przy takiej analizie AI, musimy zmierzyć się z faktem, że błędy, które potocznie nazywamy halucynacjami, nie są przypadkowymi usterkami, które można łatwo naprawić kolejną aktualizacją kodu. Wynikają one bezpośrednio z samej architektury wszystkich modeli językowych. Systemy te operują na czystej statystyce i rachunku prawdopodobieństwa, a nie na logicznym rozumowaniu czy zrozumieniu faktów. Ich zadaniem jest jedynie przewidywanie najbardziej prawdopodobnego kolejnego elementu w ciągu danych (tokenu), co sprawia, że dla algorytmu nie istnieje pojęcie obiektywnej prawdy. System z taką samą pewnością siebie wygeneruje sprawdzony fakt historyczny, jak i całkowicie zmyśloną datę czy nazwisko, jeśli tylko będą one pasowały do struktury gramatycznej i kontekstu wypowiedzi.

Problem ten staje się barierą nie do przebicia w zastosowaniach profesjonalnych, gdzie margines błędu musi wynosić zero. Zauważamy, że w obecnej formie AI wymaga nieustannego, kosztownego nadzoru człowieka. Każdy dokument, kod programistyczny czy diagnoza wygenerowana przez algorytm musi zostać zweryfikowana przez eksperta, co w wielu przypadkach podważa sens ekonomiczny wdrażania tych rozwiązań. Jeśli proces weryfikacji zajmuje tyle samo czasu, co samodzielne przygotowanie materiału od zera, to obietnica gigantycznego wzrostu produktywności staje się pustym hasłem marketingowym. Co więcej, pojawiają się uzasadnione głosy badaczy sugerujące, że ta cecha modeli probabilistycznych jest ich immanentną słabością. Oznacza to, że przy obecnej architekturze opartej na transformatorach, błędy mogą być po prostu niemożliwe do całkowitego wyeliminowania, co czyni tę technologię zawodną w systemach krytycznych.

Kolejnym aspektem, który pozwala sądzić, że obecna ścieżka rozwoju może być ślepą uliczką, jest zjawisko „zatruwania” danych treningowych. W miarę jak internet wypełnia się treściami generowanymi przez AI, przyszłe modele będą trenowane na danych stworzonych przez swoich poprzedników. Prowadzi to do zjawiska znanego jako zapaść modelu, gdzie błędy i uproszczenia poprzednich wersji są powielane i potęgowane, co w dłuższej perspektywie prowadzi do degeneracji jakości generowanych treści. Zamiast stawać się coraz inteligentniejsza, sztuczna inteligencja może zacząć powielać własne urojenia, tracąc kontakt z rzeczywistymi danymi wytworzonymi przez ludzi.

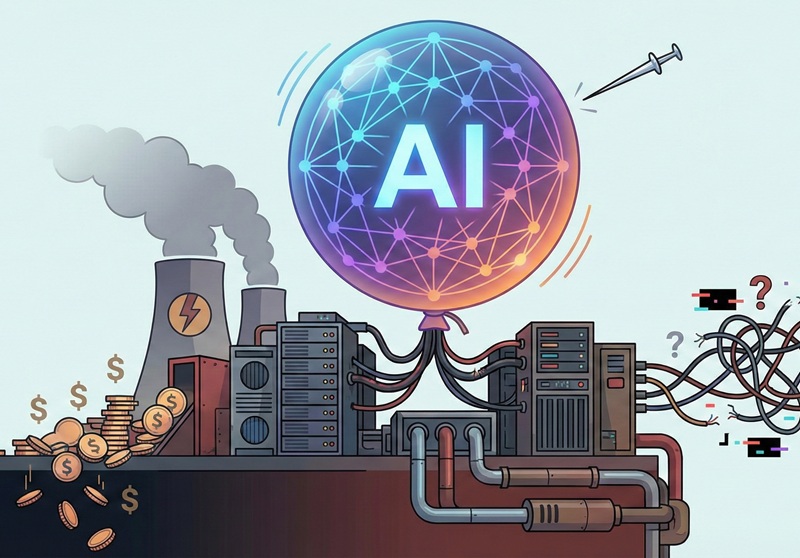

Coraz więcej analiz mówi, że obecny wzrost technologii związanych z AI może być bańką. Grafika HotGear.

Wnioski płynące z tej sytuacji są dość gorzkie dla entuzjastów pełnej autonomii maszyn. Jeśli nie nastąpi przełom w samej architekturze systemów – przejście od statystycznego zgadywania do rzeczywistego procesowania logiki i symboli – możemy utknąć z narzędziem, które jest „wiecznym stażystą”. Narzędziem, które potrafi napisać efektowny tekst lub wygenerować obraz, ale któremu nigdy nie będziemy mogli w pełni zaufać w sprawach o wysokiej stawce. Ta swoista strukturalna niepewność sprawia, że coraz więcej ekspertów zaczyna patrzeć na obecny boom z dużą rezerwą, zastanawiając się, czy nie zainwestowaliśmy wszystkich środków w technologię, która ze swej natury nigdy nie osiągnie wymaganej przez nas precyzji.

Warto przeczytać: 10 największych mitów na temat sztucznej inteligencji

Gigantyczne koszty postępu

Gdy przyglądamy się ekonomicznym fundamentom obecnego boomu na sztuczną inteligencję, z coraz większą mocą wyłania się kontrast między euforią na giełdach a twardą, nieubłaganą rzeczywistością kosztów. Rozwój potężnych modeli językowych nie jest bajką o tanim postępie – za tę technologiczną rewolucję płacimy ogromnym, wręcz bezlitosnym zużyciem zasobów, które wcale nie są tanie ani niewyczerpane. To, co napędza dzisiejszy wyścig, to nie tylko wizje przyszłości, ale bardzo realna presja na finansowe i materialne fundamenty – i coraz trudniej o prosty optymizm, gdy w tle rosną rachunki za prąd i sprzęt.

Większość użytkowników AI nie ma świadomości, że każde zapytanie skierowane do zaawansowanego czatu generuje wielokrotnie wyższe zapotrzebowanie na prąd niż tradycyjne wyszukiwanie informacji w sieci. Skalowanie tych systemów wymaga budowy gigantycznych centrów danych, które pod względem poboru mocy dorównują średniej wielkości miastom. W dobie transformacji energetycznej i rosnących cen energii, tak wysokie obciążenie sieci staje się problemem nie tylko ekologicznym, ale przede wszystkim logistycznym. Widzimy, że w niektórych regionach wydawanie pozwoleń na budowę nowych serwerowni zostaje wstrzymane, ponieważ lokalna infrastruktura nie jest w stanie dostarczyć wymaganej mocy.

Budowa infrastruktury pod AI to obecnie najdroższy wyścig zbrojeń w historii technologii. Zakup dziesiątek tysięcy wyspecjalizowanych układów graficznych, których jednostkowa cena sięga dziesiątek tysięcy dolarów, pochłania lwią część budżetów największych korporacji technologicznych. Obserwujemy zjawisko, w którym firmy takie jak Microsoft, Google czy Meta wydają dziesiątki miliardów dolarów rocznie na same centra danych i procesory, licząc na to, że w przyszłości przełoży się to na dominację rynkową.

Problem polega na tym, że dziś coraz trudniej jest uzasadnić te wydatki realnymi przychodami. Zaczynamy słyszeć głosy płynące wprost z zarządów wielkich firm, które wskazują na brak wymiernego zwrotu z tych inwestycji. Jeśli sztuczna inteligencja ma być jedynie asystentem do pisania maili czy generowania obrazków, to przychody z abonamentów mogą nigdy nie pokryć gigantycznych kosztów amortyzacji sprzętu i zużycia prądu.

W świecie finansów pojawia się coraz więcej analiz sugerujących, że rynek może znajdować się w fazie nadmiernego optymizmu. Przychodzi na myśl oczywista analogia do bańki dot-comów z przełomu wieków – tam również technologia miała ogromny potencjał, ale kapitalizacja firm była całkowicie oderwana od ich zdolności do generowania zysku. Wtedy wszystko zakończyło się gigantycznym krachem i upadkiem wielu firm z branży.

Obecnie stoimy przed ryzykiem, że jeśli w najbliższym czasie nie pojawią się przełomowe, masowe zastosowania AI, które będą generować realną gotówkę, strumień inwestycji może nagle wyschnąć. Korporacje, pod presją akcjonariuszy, mogą zostać zmuszone do drastycznego cięcia wydatków na rozwój modeli, co doprowadzi do gwałtownego spowolnienia całej branży. W takim scenariuszu AI nie tyle „zniknie”, co przestanie być traktowana jako priorytet, stając się jedynie kolejną, niszową usługą chmurową.

Podsumowanie

Podsumowując, trzeba przyznać, że stoimy w obliczu jednego z najbardziej fascynujących, a zarazem niebezpiecznych momentów w historii technologii. Sztuczna inteligencja, mimo swoich licznych i obiektywnych wad, nie jest jedynie pustą obietnicą. Widzimy jej realną wartość w codziennych zadaniach – od optymalizacji procesów logistycznych, przez wsparcie w pisaniu kodu, aż po błyskawiczną analizę ogromnych zbiorów danych, która człowiekowi zajęłaby tygodnie. To narzędzie, które już teraz realnie zmienia sposób, w jaki pracujemy i wchodzimy w interakcję z maszynami.

Jednak ta sama technologia znalazła się dziś na wyraźnym rozdrożu. Z jednej strony mamy potężną presję na dalszy rozwój i wszechobecność, a z drugiej – coraz twardszą ścianę w postaci ograniczeń fizycznych i ekonomicznych. Nie możemy ignorować faktu, że obecny model rozwoju, oparty na „karmieniu” algorytmów coraz większą ilością danych i energii, zaczyna wykazywać oznaki wyczerpania. Jeśli nie nastąpi jakościowy przełom, który pozwoli wyeliminować błędy strukturalne i drastycznie obniżyć koszty eksploatacji, entuzjazm inwestorów może gwałtownie wygasnąć, co doprowadzi do bolesnej korekty całego rynku.

Wydaje się zatem, że zamiast spektakularnego „wybuchu” bańki, czeka nas raczej okres brutalnej weryfikacji użyteczności. Przetrwają te rozwiązania, które niosą ze sobą konkretną korzyść ekonomiczną i są na tyle niezawodne, by mogły działać bez nieustannego nadzoru człowieka. Przyszłość AI nie musi oznaczać jej upadku, ale niemal na pewno wiąże się z końcem ery bezkrytycznego zachwytu. Wkraczamy w czas, w którym od sztucznej inteligencji będziemy wymagać nie tylko efektownych odpowiedzi, ale przede wszystkim odpowiedzialności, precyzji i rentowności.

Tomasz Sławiński